シャドーAIの現実:Catoの調査結果から見えてきたもの

AIツールは、すでに職場において確かな価値を発揮しています。文章の作成や調査、コーディング、計画立案、業務の自動化などを支援し、従業員の作業をより速く、より効率的にします。企業にとっても、これまで不可能だったスピードで意思決定やイノベーションを進めることを可能にしています

しかし、AIの急速な普及は、IT部門が主導して設計したものではありませんでした。必ずしも正式な導入計画や調達プロセスを経て広がったわけではなく、人気の生成AIをはじめとするツールへのリンクが共有され、ユーザーが自ら判断して、わずか数分で使い始める—そんな形で浸透していったのです。

当初は「この研究論文を要約してほしい」といった軽い用途だったものが、やがて契約書の作成、コード生成、SQLクエリの作成、顧客とのコミュニケーションにまで利用範囲が拡大しました。その結果、企業は深刻な情報漏えいリスクに直面し、攻撃対象領域は内部から外側へと押し広げられています。AIツールは意図せずして、企業の管理が及ばないモデルへ機密データが流れ込む状況を生み出し、「シャドーAI」という拡大しつつある新たな課題を引き起こしているのです。

Cato survey results show that shadow AI governance lags as AI adoption soars | Read the PR調査結果が示すもの

Catoはこのたび、シャドーAIに対する認識を把握するため、世界各地のITリーダー600名以上を対象に調査を実施しました。その回答からは、明確な傾向が浮かび上がっています。未承認ツールの利用はすでに一般化しており、リスクは拡大を続けている一方で、ガバナンスの整備は後手に回っているという実態です。

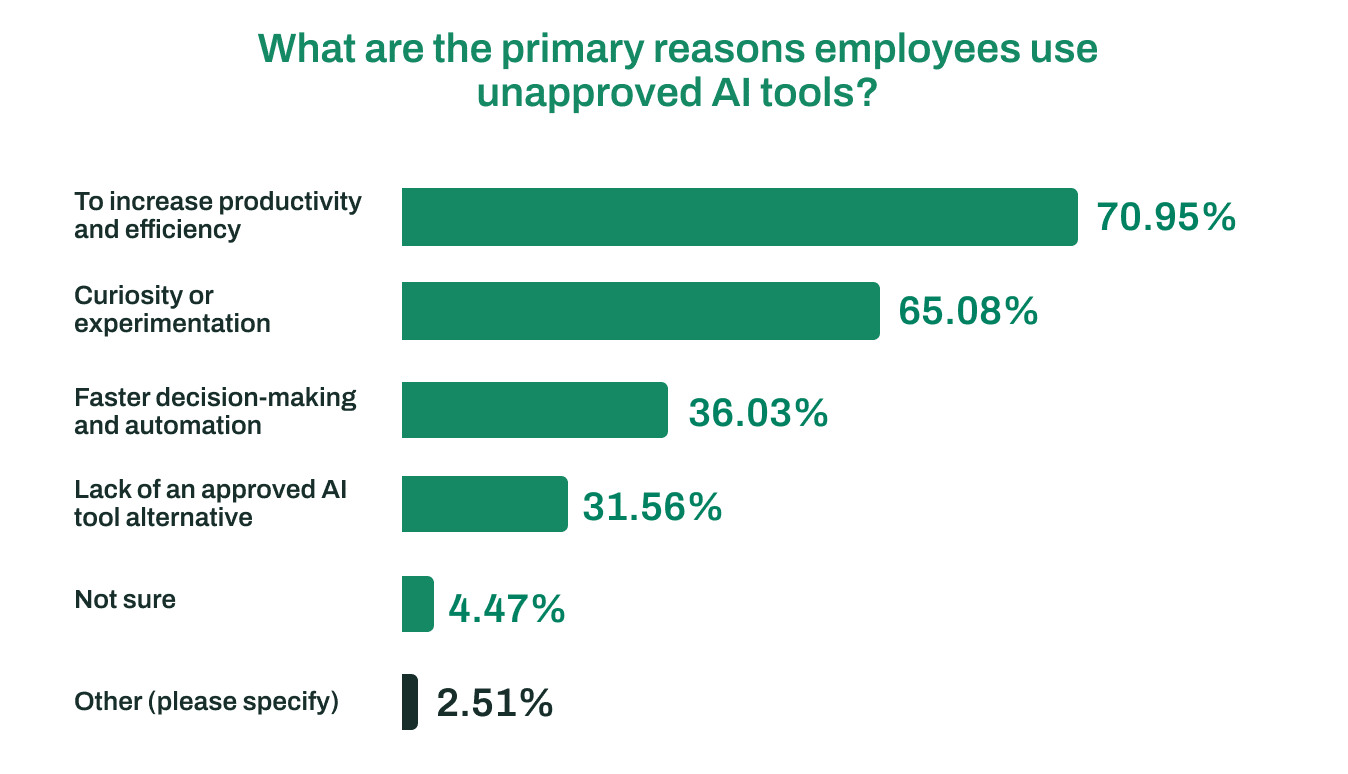

多くのユーザーがAIを導入している理由は、成果をより速く、より良いものにでき、生産性が向上するからです。実際、調査回答者の約71%が、従業員が未承認のツールを使用する最大の理由として「生産性と効率の向上」を挙げています。時間を節約でき、明確な価値をもたらすツールであれば、それが正式に承認されているかどうかに関わらず、人は使ってしまう—それが現実なのです。

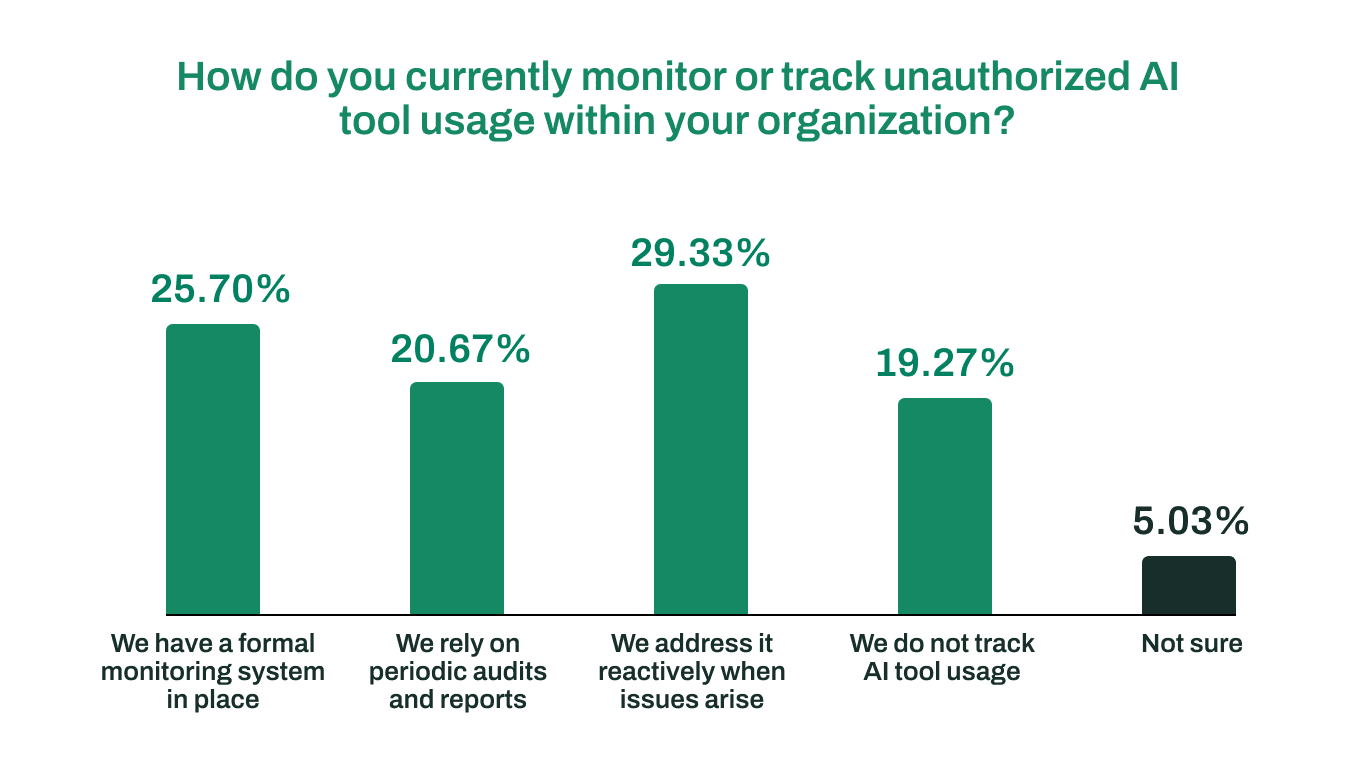

多くのIT部門では、AIの利用実態を十分に把握できていない、あるいはほとんど可視化できていないのが現状です。従業員がどのAIツールを使っているのか、利用頻度はどれくらいなのか、どのような情報を入力・共有しているのか、さらにはそれらのツールがデータをどのように処理・活用しているのかまでは、見通せていないのです。実際、全体の69%の組織はいまだに正式なモニタリング体制を導入しておらず、不定期の監査や事後的な対応に頼っている、あるいは利用状況をまったく把握していないケースも少なくありません。

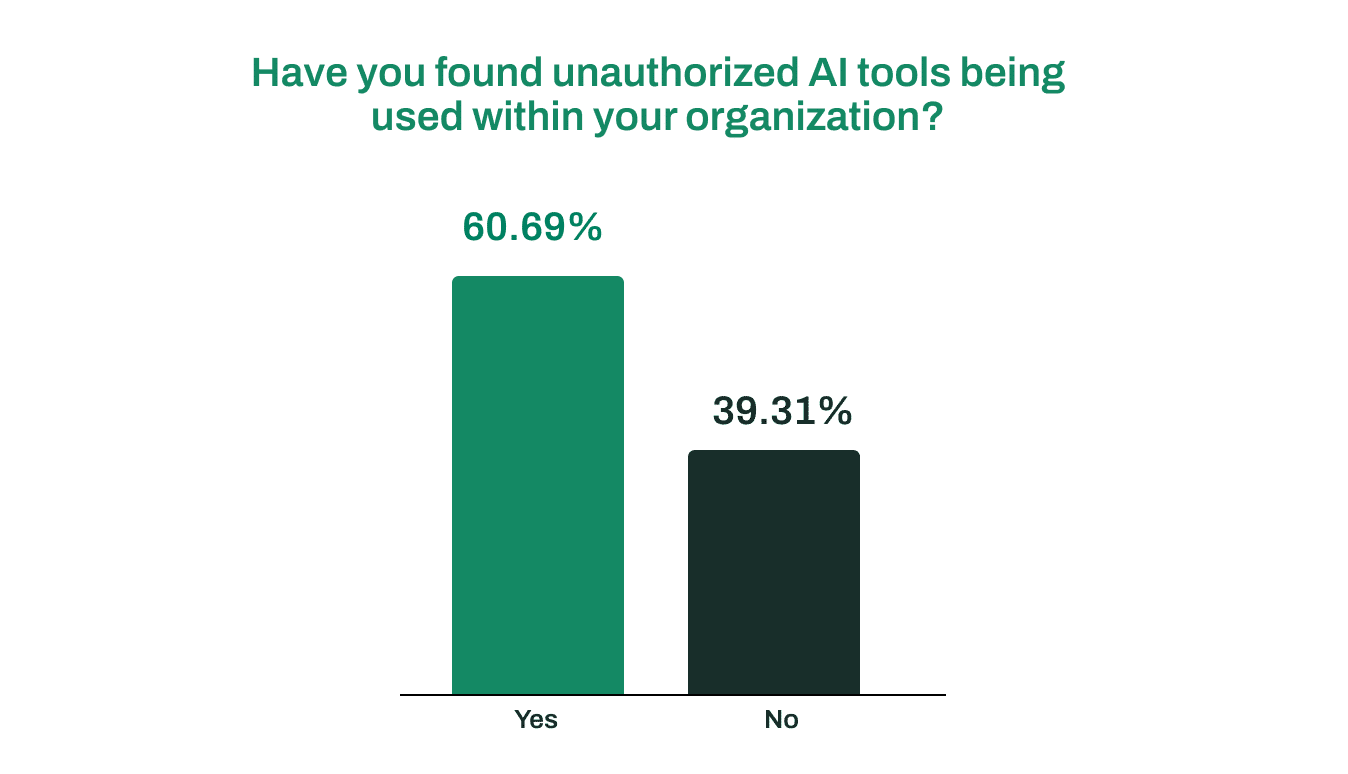

こうした監視や可視性の欠如がもたらす結果は、ある意味で想定どおりとも言えます。調査回答者の約61%が、すでに自社環境内で未承認のAIツールを確認したと回答しています。それらのツールでは、利用ルールやガバナンスが整備されないまま、企業の機密データが入力・利用されているのが実態です。

こういった状況に対する懸念は、広く共有されています。調査対象者の53%が、未承認のAIツールによって生じるリスクについて「非常に懸念している」または「極めて懸念している」と回答しました。一方で、「まったく懸念していない」と答えた回答者は、わずか3%強にとどまっています。

シャドーAIは、シャドーITをはるかに上回るリスクを孕んでいる

シャドーAIは、従来のシャドーITが内包していたリスクを土台としながら、それをはるかに上回る複雑で深刻な課題をもたらします。未承認のSaaSツールであれば、データが漏えいする可能性はあるにせよ、少なくともどこに存在しているのかを追跡できる余地はありました。しかし、AIツール、とりわけ生成AIの場合、データは単にどこかに保管されるだけではありません。入力された情報は処理され、学習に取り込まれ、意図しない形で出力の中に再び現れる可能性があります。一度AIツールに共有された情報は、その後どのように利用・再利用されているのかを追跡することがほぼ不可能です。この点が、企業にとって深刻なコンプライアンス上の悪夢を生み出しているのです。

多くのIT部門は、この現実に対応しきれていない

シャドーAIはすでに日常業務の一部となっていますが、そのリスクを十分に管理できていると感じている組織は多くありません。調査では、自社がこれらのリスクへの対応に「非常に効果的である」と回答したのは、わずか13%にとどまりました。AIがビジネスのほぼあらゆる領域に関わり始めている現状を考えると、この数字は明らかに不十分です。

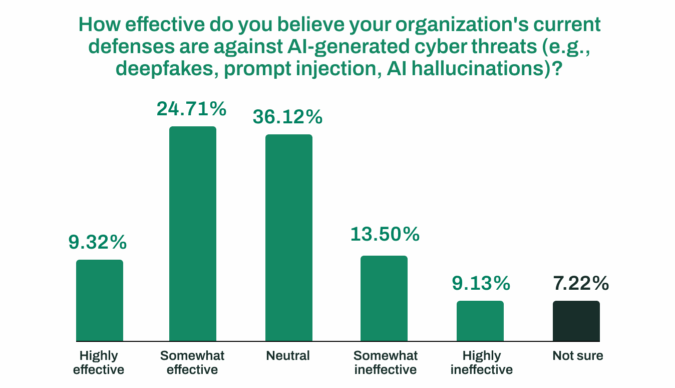

脅威への備えという観点では、状況はさらに厳しくなります。ディープフェイク、プロンプトインジェクション、フィッシング、モデル改ざんといったAI生成型の攻撃に対して、「非常に効果的に防御できている」と答えたのは、わずか9%でした。攻撃者は、ほぼあらゆる攻撃手法や戦術において、AIツールを活用しています。

十分なリソースを備えた防御側のチームであっても、攻撃者によるAIツールの利用と悪用の規模やスピードに追いつくのは容易ではありません。さらに、自社環境の可視性が不十分な場合、AIがどのように使われて攻撃されているのかを見極めることは、いっそう困難になります。

しかし、本当の問題はシャドーAIそのものなのでしょうか?

シャドーAIが広がった背景には、多くの従来型セキュリティアーキテクチャが、シャドーAIや、それが前提とする分散型の利用環境を想定して設計されていなかったという構造的な問題があります。断片的に導入されたセキュリティソリューションでは、どのAIツールが使われているのか、誰が使っているのか、そして何の目的で使われているのかを把握することができません。可視性、コンテキスト、制御が分断され、人の判断や対応に依存している状態では、AIは見えないまま存在し続け、予測不能なリスクとなります。

AIと共に生まれた、AIの為のアーキテクチャ

企業はAIを禁止したいわけではありません。利用状況を可視化し、適切に制御し、ガバナンスを効かせることができれば、AIがもたらす価値は、そのリスクをはるかに上回ります。正しいセキュリティアーキテクチャのもとでは、AIは負担ではなく、明確な競争優位へと変わります。

Cato SASE Cloudは、セキュリティ、ネットワーク、アクセスを、単一のクラウドネイティブかつAIネイティブなプラットフォーム上に統合します。これにより、従業員が利用しているAIツールを包括的に可視化し、その利用を安全に維持するための基盤を提供します。また、制御機能によって、機密データの社外流出を防止し、不適切な利用を制限し、リスクの高い挙動をリアルタイムで検知します。Catoを活用することで、企業はAIの導入と活用を、可視性・セキュリティ・ガバナンスを確保したうえで、大規模に推進することが可能になるのです。

最新の調査について、ぜひご意見をお寄せください

現在、私たちは、来年のサイバーセキュリティの動向を形作ると考えられる脅威について、ITおよびセキュリティの専門家の皆さまから知見を集めています。今後、どのような脅威が現れると予測しますか?ぜひ「2026年サイバー脅威調査」にご参加いただき、あなたの視点を共有してください。ご協力いただいた方には、感謝のしるしとしてCatoから記念品をお送りします。