GenAI-Sicherheit entmystifiziert – und wie Cato Ihnen hilft, den Zugriff Ihrer Organisation zu ChatGPT zu sichern

Im vergangenen Jahr wurden unzählige Artikel, Vorhersagen, Prophezeiungen und Warnungen über die Risiken von KI geschrieben, wobei GenAI (Generative AI) und ChatGPT im Mittelpunkt standen. Das Spektrum reicht von der Ethik bis hin zu weitreichenden Auswirkungen auf die Gesellschaft und Arbeitskräfte („Nein, Mama, der Terminator wird erstmal nicht Wirklichkeit…“).

Die Vorhersagen und Befürchtungen haben Cato Security Research and Engineering so fasziniert, dass wir uns entschlossen haben, die Risiken von ChatGPT für Unternehmen zu untersuchen. Unsere Ergebnisse lassen sich in mehreren zentralen Schlussfolgerungen zusammenfassen:

- Für Unternehmen, die ChatGPT und ähnliche Dienste nutzen, gibt es derzeit mehr Panikmache als reale Risiken.

- Die Produktivitätsvorteile überwiegen die Risiken bei weitem.

- Dennoch sollten Unternehmen Sicherheitskontrollen einrichten, um zu verhindern, dass ihre sensiblen und geschützten Informationen in Tools wie ChatGPT verwendet werden, da sich die Bedrohungslage schnell ändern kann.

Die untersuchten Bedenken

Der Datenschutzaspekt von ChatGPT und die zugrundeliegende GenAI-Technologie machen einen großen Teil dieser Panikmache aus. Es geht darum, was genau mit den Daten geschieht, die in ChatGPT ausgetauscht werden, wie sie verwendet (oder nicht verwendet) werden um das Modell im Hintergrund zu trainieren, wie sie gespeichert werden (wenn sie gespeichert werden), und so weiter.

Problematisch ist das Risiko von Datenverlusten und Datenlecks in Bezug auf das geistige Eigentum des Unternehmens, wenn Benutzer mit ChatGPT interagieren. Typische Szenarien sind:

- Mitarbeiter, die ChatGPT nutzen: Ein Benutzer lädt geschützte oder vertrauliche Informationen auf ChatGPT hoch – z. B. ein Softwareentwickler, der einen Codeblock zur Überprüfung durch die KI hochlädt. Könnte dieser Code später durch Antworten (versehentlich oder böswillig) in andere Konten gelangen, wenn das Modell diese Daten zum weiteren Training verwendet?

Spoiler: Dies ist unwahrscheinlich, und es wurden auch keine konkreten Beweise für eine systematische Ausbeutung veröffentlicht. - Datenverluste durch den Dienst selbst: Welches Risiko besteht für eine Organisation, die ChatGPT nutzt, wenn OpenAI Datenleaks erleidet oder Benutzerdaten durch Fehler in ChatGPT offengelegt werden? Könnten sensible Informationen auf diese Weise durchsickern?

Spoiler: Möglicherweise, von OpenAI wurde mindestens ein öffentlicher Vorfall gemeldet, bei dem einige Nutzer aufgrund eines Fehlers in der OpenAI-Infrastruktur Chat-Titel anderer Nutzer in ihrem Konto sehen konnten. - Proprietäre GenAI-Implementierungen: KI verfügt bereits über ein eigenes MITRE-Angriffs-Framework, ATLAS, mit Techniken, die von Eingabemanipulation bis zu Datenexfiltration, Datenvergiftung, Inferenzangriffen usw. reichen. Könnten die sensiblen Daten eines Unternehmens durch diese Methoden gestohlen werden?

Spoiler: Ja, die Methoden reichen von harmlos über theoretisch bis hin zu praktisch, wie in einem kürzlich erschienenen Artikel von Cato Research zu diesem Thema beschrieben. Die Sicherung der proprietären Implementierung von GenAI ist nicht Gegenstand dieses Artikels.

Alles, was wir tun, birgt immer ein Risiko. Auch im Internet besteht ein Risiko, aber das hält Milliarden von Nutzern nicht davon ab, es jeden Tag zu nutzen. Man muss nur die entsprechenden Vorsichtsmaßnahmen treffen. Das Gleiche gilt für ChatGPT. Zwar sind einige Szenarien wahrscheinlicher als andere, aber wenn man das Problem vom praktischen Standpunkt aus betrachtet, kann man einfache Sicherheitskontrollen einführen, um sich keine Sorgen zu machen.

Everything You Wanted To Know About AI Security But Were Afraid To Ask | Watch the WebinarGenAI-Sicherheitskontrollen

Diese Anwendungsfälle sind in einer modernen SASE-Architektur, die CASB und DLP als Teil der Plattform enthält, leicht zu handhaben. Die Plattform von Cato tut genau das: Sie bietet einen mehrschichtigen Ansatz, um zu gewährleisten, dass ChatGPT und ähnliche Anwendungen innerhalb des Unternehmens verwendet werden:

- Kontrollieren Sie, welche Anwendungen erlaubt sind und welche Benutzer/Gruppen diese Anwendungen nutzen dürfen.

- Kontrollieren Sie, welche Texte/Daten übermittelt werden dürfen

- Anwendungsspezifische Optionen werden durchgesetzt, z.B. Ablehnung der Vorratsdatenspeicherung, Mandatenkontrolle etc.

Der erste Ansatz besteht darin, festzulegen, welche KI-Anwendungen zulässig sind und welche Nutzergruppen sie verwenden dürfen. Dies kann durch eine Kombination aus der Anwendungskategorie „Generative KI-Werkzeuge“ und den spezifischen Werkzeugen, die zugelassen werden sollen, erfolgen, z.B. indem alle GenAI-Werkzeuge gesperrt werden und nur „OpenAI“ zugelassen wird.

Ein weiterer Baustein fortschrittlicher DLP-Lösungen ist die Fähigkeit, Daten zuverlässig zu klassifizieren. Die bisherigen Ansätze des exakten Datenabgleichs, der statischen Regeln und der regulären Ausdrücke sind für sich genommen nahezu überholt. Beispielsweise wäre das Blockieren einer Kreditkartennummer mit einem regulären Ausdruck einfach, aber in realen Szenarien mit Finanzdokumenten gibt es viele andere Möglichkeiten, wie sensible Informationen nach außen gelangen können. Ohne eine fortschrittliche Lösung, die einfach funktioniert, wäre es nahezu unmöglich, mit den sich ändernden Daten und der Feinabstimmung der Richtlinien Schritt zu halten.

Glücklicherweise ist das genau der Punkt, an dem die ML (Machine Learning) Data Classifiers von Cato ins Spiel kommen. Dies ist die neueste Ergänzung der bereits umfangreichen KI/ML-Funktionalität, die Cato im Laufe der Jahre in die Plattform integriert hat. Unser hauseigenes LLM (Large Language Model), das an Millionen von Dokumenten und Datentypen trainiert wurde, kann Dokumente in Echtzeit identifizieren und ist damit das perfekte Werkzeug für solche Richtlinien.

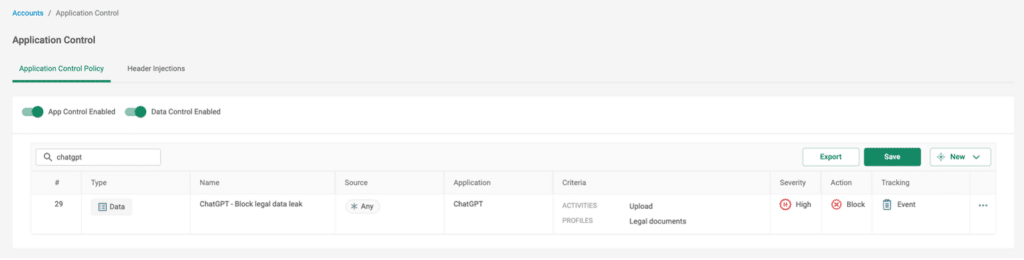

Betrachten wir das Szenario, in dem bestimmte Texteingaben mit ChatGPT blockiert werden, z.B. das Hochladen von vertraulichen oder sensiblen Daten über die Eingabeaufforderung. Angenommen, ein Mitarbeiter der Rechtsabteilung entwirft eine Geheimhaltungsvereinbarung (Non Disclosure Agreement, NDA) und gibt sie vor der Fertigstellung an ChatGPT weiter, damit dieser sie durchsieht, Verbesserungsvorschläge macht oder auch nur die Grammatik überprüft. Dies könnte natürlich einen Verstoß gegen die Datenschutzbestimmungen des Unternehmens darstellen, insbesondere wenn das Dokument personenbezogene Daten enthält.

Abbildung 1 – Beispielregel, die ML-Klassifikatoren verwendet, um das Hochladen von Rechtsdokumenten zu blockieren

Lassen Sie uns noch tiefer eintauchen

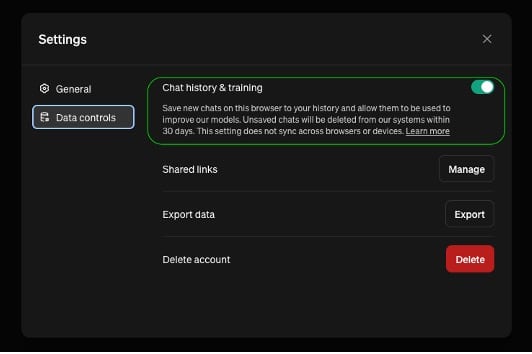

Wir wollen einen weiteren Aspekt der Datenschutzkontrollen von ChatGPT untersuchen, um die Leistungsfähigkeit und Flexibilität einer umfassenden CASB-Lösung weiter zu demonstrieren. In den Einstellungen gibt es eine Option zum Deaktivieren von „Chat-Verlauf & Training“. Damit kann der Benutzer entscheiden, dass seine Daten nicht für das Training des Modells verwendet und auf den Servern von OpenAI gespeichert werden sollen.

Diese wichtige Datenschutzkontrolle ist standardmäßig deaktiviert, d.h. standardmäßig werden alle Chats von OpenAI gespeichert, sodass die Benutzer entscheiden müssen, was ihre Organisation bei allen arbeitsbezogenen Aktivitäten mit ChatGPT vermeiden sollte.

Abbildung 2 – ChatGPTs Datenkontrollkonfiguration

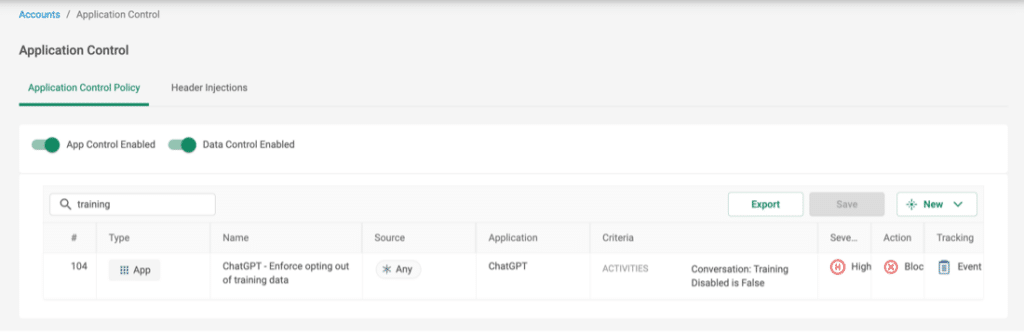

Ein guter Weg, um ein Gleichgewicht zwischen der Flexibilität der Benutzer bei der Nutzung von ChatGPT und einer strengeren Kontrolle zu erreichen, ist es, nur Chats in ChatGPT zuzulassen, bei denen der Chat-Verlauf deaktiviert ist. Die granulare ChatGPT-Anwendung von Catos CASB ermöglicht diese Flexibilität, indem sie in Echtzeit erkennt, ob ein Benutzer für den Chat freigeschaltet ist, und die Verbindung blockiert, bevor Daten gesendet werden.

Abbildung 3 – Beispielregel für die Durchsetzung des „Trainings-Opt-outs“

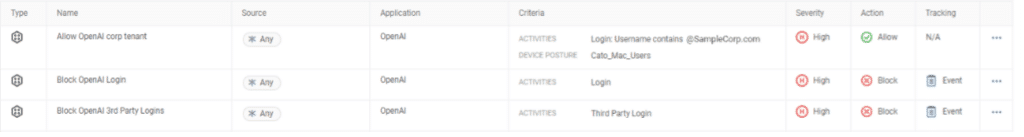

Alternativ (oder ergänzend) zum obigen Ansatz ist es möglich, Mandantenkontrolle für den ChatGPT-Zugriff zu konfigurieren, d.h. zu erzwingen, welche Konten auf die Anwendung zugreifen dürfen. Ein mögliches Szenario ist, dass eine Organisation Unternehmenskonten bei ChatGPT hat, wo sie voreingestellte Sicherheits- und Datenkontrollrichtlinien für alle Mitarbeiter durchgesetzt hat, und sicherstellen möchte, dass die Mitarbeiter nicht mit ihren persönlichen Konten auf das kostenlose ChatGPT-Angebot zugreifen.

Abbildung 4 – Beispielregel für die Mandantenkontrolle

Um mehr über CASB und DLP von Cato zu erfahren, besuchen Sie: